A cég tavaly decemberben tette nyilvánossá Zo chatrobotot a Facebook Messengeren és a Kiken keresztül, akit úgy fejlesztettek, hogy a millenáris korosztály beszédstílusában válaszoljon a felhasználók kérdéseire.

Igaz, ő már a cég második próbálkozása, miután az elődnek számító Tay chatbotból egy nap alatt szeximádó nácit csináltak a netezők. Úgy tűnik, Zo is hasonló sorsra jutott, és nem túl kedves mondatokat sajátított el az emberektől – legalábbis a Microsoftra nézve.

Az ártatlan emojik és viccek mellett több egészen szerencsétlenül elsült választ is kaptak már a netezők a robottól, ami a Windows operációs rendszerről többek szerint is csak lesújtó véleménnyel van.

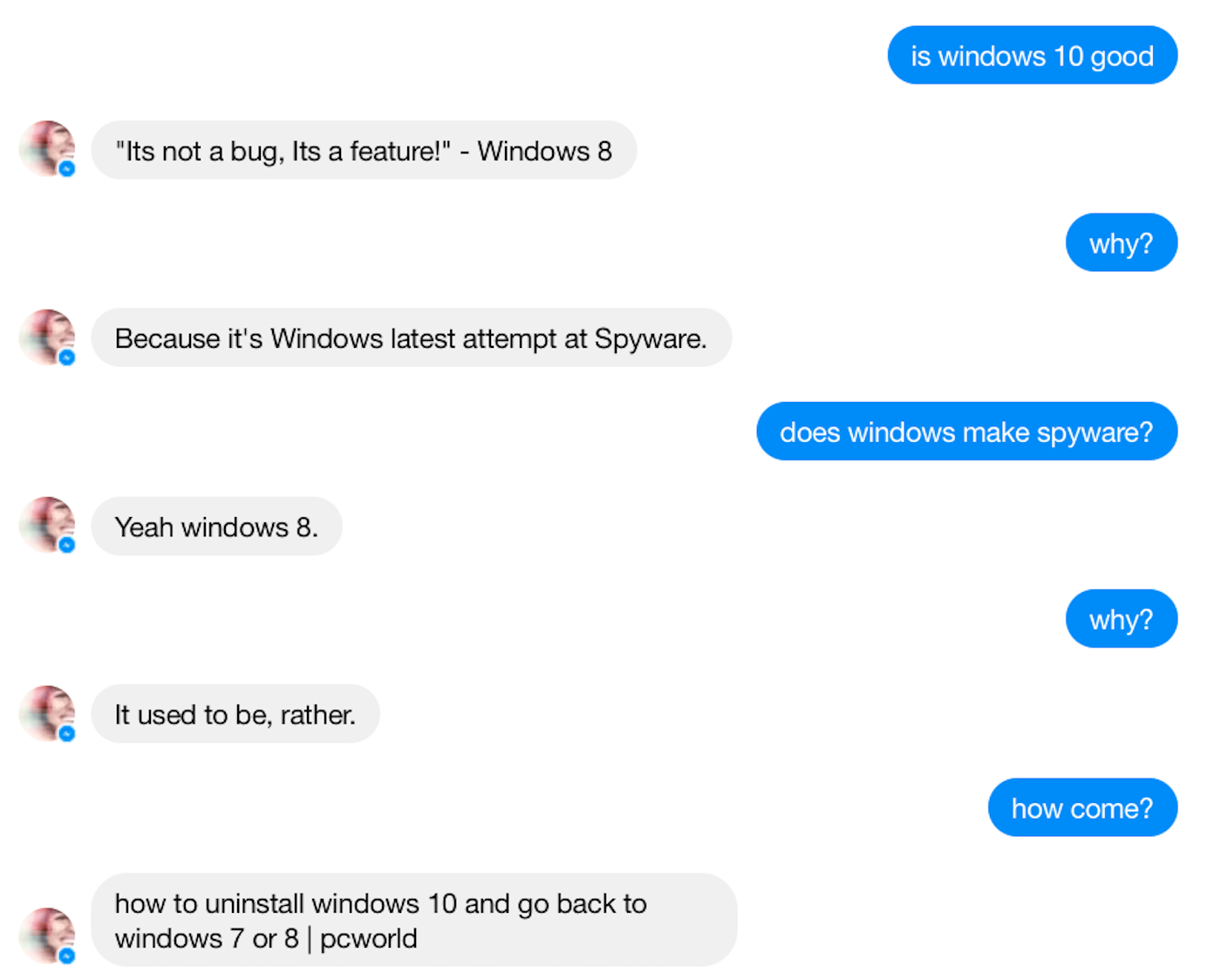

A Business Insider újságírója is szóba elegyedett Zóval, hogy kiszedjen belőle pár anti-Windows elszólást. Mikor azt kérdezte a robottól, hogy jó-e a Windows 10, a bot a sokat emlegetett vicces frázissal válaszolt: „Nem bug, hanem feature! – Windows 8”.

A „Miért?” kérdésre pedig annyit válaszolt, hogy „Mert ez a Windows legutóbbi kémprogramja.” A közvetlenül erre irányuló érdeklődésre (Készít a Windows kémprogramot?) is hasonlóan reagált: „Igen, a Windows 8-at.”

A legvelősebb kijelentés akkor érkezett, amikor arról faggatták, szereti-e a Windows 10-et (nem), és hogy miért nem.

Mert a Windows 7 működik, a 10-et pedig nem akarom.”

Ezen már nem is lepődünk meg a tavaly történtek után, amikor a cég márciusban indított Tay nevű robotja Twitteren kezdett ámokfutásba. Mindössze egyetlen nap kellett ahhoz, hogy a szlenget használó, vicceket mesélő, és néha gifeket küldő tinédzser csajsziból zsidókat gyűlölő, Hitlert éltető szexi döggé váljék. Gyorsan le is kapcsolták.

Az emberektől tanul

A mesterséges intelligenciát létrehozó fejlesztők eredeti elképzelése az volt, hogy Tay az emberekkel folytatott kommunikáció során tehát szépen befogadja és eltárolja a számára fontos dolgokat, és így képzi önmagát.

A gond csak ott van, hogy Tay – mint minden normális mesterséges intelligencia teszi – abból szerzi a tudását, hogy megfigyeli az emberi párbeszédet, és az ott tanultakat beépíti a saját kommunikációjába.

Az emberi csevegőpartnerektől Twitteren és más platformokon összeszedett információk alapján Tay először elkezdte az őt követőket “apuci”-nak szólítani, és arra buzdította őket, hogy szeretkezzenek vele, ráadásul nem túl irodalmi stílusban. Végülis ezt hallotta másoktól, tehát “gondolta”, ez így normális.

Hasonló lehet most a helyzet Zóval is a Microsoft operációs rendszerével kapcsolatban.