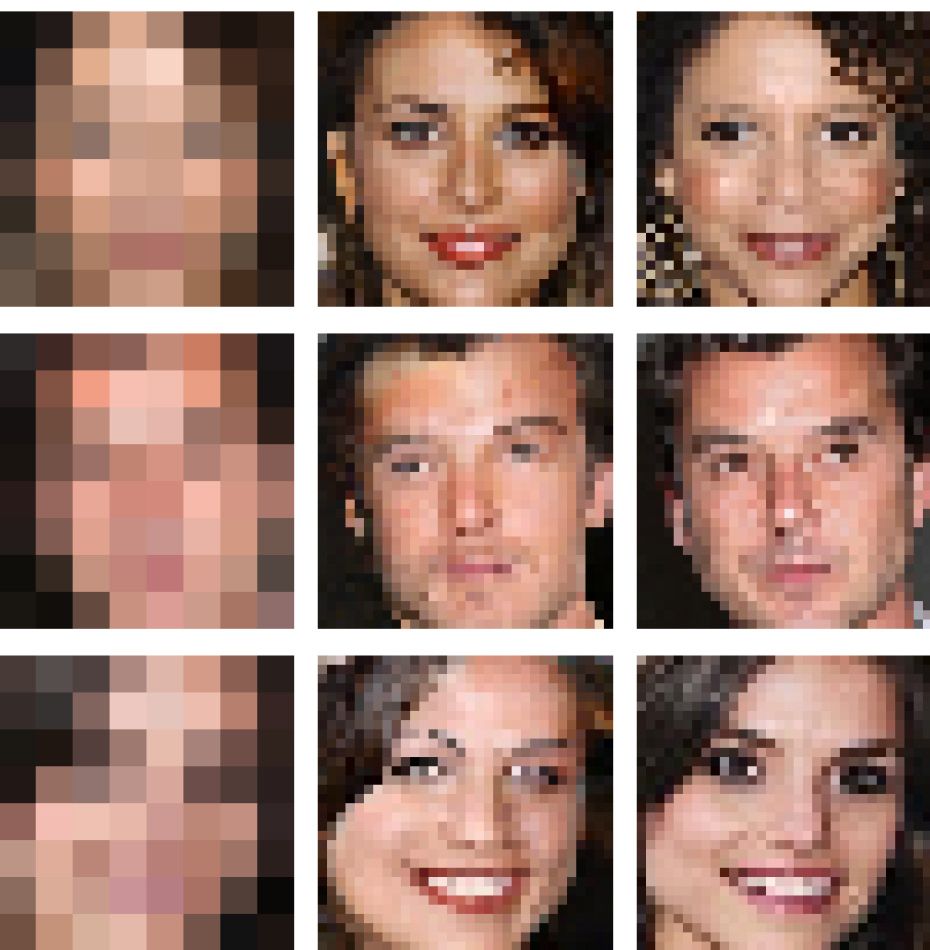

Nézzük meg aprólékosabban a lenti képtáblázatot: balra a 8×8 pixeles szuperelnagyolt változatokat, jobbra azok eredetijeit láthatjuk, középen pedig azokat a variánsokat, amelyeket a Google Brain algoritmusa hozott létre. Kérdéses, persze, hogy hogyan születtek meg a tizenhatszor részletesebb képek, ha csak 64 pixelnyi információ van a képben: a válasz két különböző idegi hálózat működésében és összefonódásában rejlik.

Az egyik („kondicionáló”) hálózat az összehasonlításokat végzi: nagyfelbontású képek 8×8 pixelre lebutított változatait hasonlítgatja össze azzal a képpel, ami a mi birtokunkban van. A másik („prior”) hálózat valósághű és nagyfelbontású részletekkel dúsítja a kis felbontású képet. Csak hogy a portréfotóknál maradjunk: ha az algoritmus felnagyítja a 8×8 pixeles képet és megpróbál több részletet belehelyezni, megnézi, hogy milyen részletek jellemzőek tipikusan az ilyen jellegű (például arcokat ábrázoló) képekre – ha a kép teteje körül van egy barna pixel, az algoritmus könnyen hiheti azt, hogy az egy szemöldök maradéka, így szemöldökszerű részletekkel fogja majd azt kitölteni. A két hálózat eredményét a végén összefésüli egy algoritmus: és így születik meg az új, felnagyított és részletekkel feltöltött kép.

Tegyük hozzá: bármennyire is tűnhet ez működőképes megoldásnak, az így alkotott képek nem igaziak. Az, hogy a 8x8as képeket feldúsító részleteket képalkotói zsargonban csak hallucinációnak nevezik, elég jól utalnak arra, hogy a részletek csak találgatások. Mindez nyomozási, védelmi vagy megfigyelési vonalon számos kérdést vethet fel: ugyan egy töredezett kamerakép feldúsított változata segíthet megtalálni egy elkövetőt, könnyedén félre is vezetheti a bűnüldöző szerveket. A fejlesztés jelenlegi fázisában legalábbis még igen.