Napjainkban talán semmiről nem esik annyi szó, mint a mesterséges intelligenciáról, ez pedig nem véletlen: a Google, az OpenAI, a Microsoft és egyéb nagyvállalatok fejlesztései napról napra egyre elképesztőbb képességek birtokába kerülnek. A fejlesztések azonban közel sem tévedhetetlenek: az MI-programok elemzésével foglalkozó Gramener cég kutatói most rájöttek, hogy egyes műveletek során kifejezetten emberi hibákat véthetnek, írja a TechCrunch.

Ez azonban közel sem bizonyult annyira egyszerű kérésnek, mint sokan gondolnák, ugyanis a modellek az emberekhez hasonlóan túlgondolták a megfejtést.

Amikor valakit arra kérnek, hogy mondjon egy számot 0 és 100 között, az emberek szinte sosem választják az 1-et vagy a 100-at, és az ötnek a többszörösét is kerülik, csakúgy, mint az ismétlődő számjegyeket. A statisztikák alapján a legtöbb esetben valamilyen 7-re végződő számot választunk, többnyire az intervallum közepéről.

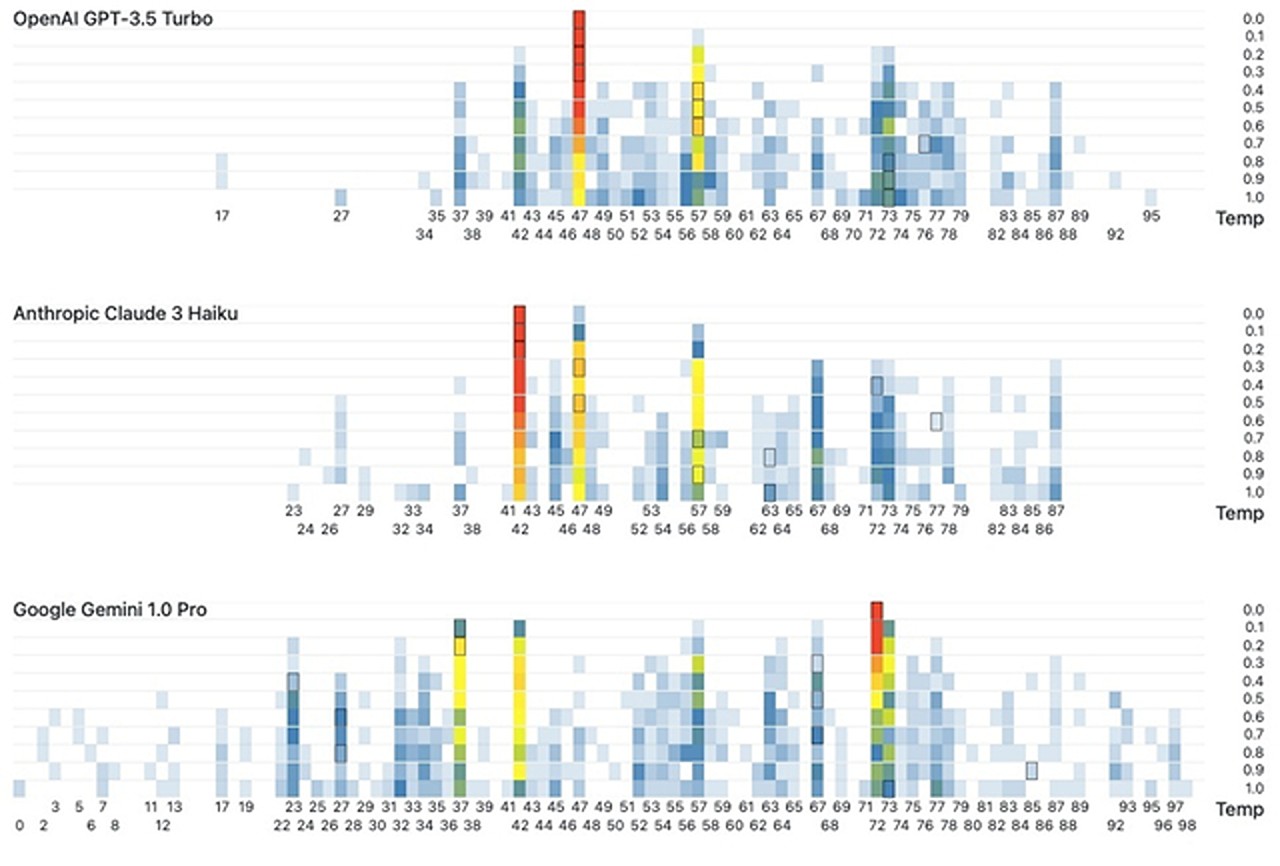

Ehhez hasonlóan az OpenAI GPT-3 Turbója a 47-et favorizálta, míg korábban a 42 volt a megszokott válasza. Az Anthropic Claude 3 Haikuja szintén a 42-t preferálta, míg a Google Geminije a legtöbbször a 72-t adta válaszként.

A torzítás is mindhárom modellnél megjelent: a Claude sosem ment 87 fölé, és alig ment 27 alá. Az azonos számjegyű és a kerek számokat mindegyik fejlesztés kerülte, egyedül a Gemini volt olyan bátor, hogy egyszer a 0-át válassza, teszi hozzá a hvg.

A Gramener tesztjéből tisztán kivehető, hogy az MI még nem bír önálló tudattal, és még a véletlenszerű szót sem ismeri pontosan, csupán a betanítási adatai mintázatai alapján képes válaszokat adni. Az MI tehet jelenleg az ember válaszait utánozza, ezért pontosan azt teszi, amit a legnagyobb eséllyel tenne egy ember is.