Október 4-én világszerte leálltak a Facebook szolgáltatásai. A közel hat órán át tartó szünet a routerek konfigurációs beállításának változása miatt következett be, gyakorlatilag megállt a cég egész felhős infrastruktúrája. Ez volt a közösségi óriás legnagyobb leállása 2019 tavasza óta, akkor közel egy órára teljesen elérhetetlenné vált a Facebook, majd egy napon keresztül akadozott a szolgáltatás. A mostani eset azért nyúlhatott ilyen hosszúra, mert az elhárításhoz a helyszínre kellett vonulni a szakembereknek, és a technikai hiba elég mélyre nyúlt. Egy hibás beállítás miatt az úgynevezett routerek egyszerűen nem találták meg a Facebook infrastruktúráját. A közösségi óriás szerverei nem tudtak kapcsolódni az internethez, sem a szervereket tároló adatközpontok egymáshoz.

A cég magyarázó posztja szerint minden nagyon gyorsan történt, és mire a mérnökök rájöttek, hol a probléma, két akadály gördült eléjük: nem tudták elérni az adatközpontjaikat a megszokott módon, mert nem működött a hálózat, illetve a belsős eszközeiket sem tudták használni.

és a benn lévő hardvereket és routereket is úgy tervezték, hogy nehezen lehessen módosítani a beállításaikat. Így extra idő kellett aktiválni azokat a megoldásokat, amivel megkezdődhetett a munka. De mégis hova kellett elmenni – hol található a Facebook a fizikai valójában?

A Facebook valójában több épület

A közösségi óriás szolgáltatásai olyan szerverekre támaszkodnak, amik a világ különböző pontjain lévő adatközpontokban vannak elhelyezve. Ez az infrastruktúra szolgáltatja a különféle alkalmazások futtatásához szükséges hátteret. A teljes működést részletezni bonyolult lenne, de olvasóinknak érdekességként elmagyarázzuk, hogyan működnek és mik ezek az adatközpontok, ahol a szelfijeink, az üzeneteink és az instaposztjaink pihennek.

Érdemes belegondolni abba, hogy mi magunk mennyi adatot termelünk csak azzal, hogy jelen vagyunk a Facebookon. Ez rengeteg képet, interakciót jelent – hogy pontosan mit tárol rólunk a cég, magunk is letölthetjük és megnézhetjük, erről itt írtunk korábban. Most ezt fokozzuk azzal, hogy csak a Facebook közösségi oldalnak már több mint havi 2,5 milliárd aktív felhasználója van, és akkor még nem is beszéltünk az Instagramról, a WhatsAppról.

Az adatközpont egy különleges környezet, ami számítógépszobákból áll, a rackszekrények mellett különféle rendszerezők találhatók benne a szükséges kábelekkel. Különálló épületek, amik lényege, hogy ott biztonságosan üzemelhessenek a szerverek. Természetesen ehhez hozzátartozik, hogy a nap 24 órájában monitorozzák ezeket a rendszereket.

Az ilyen központok rengeteg áramot fogyasztanak és hőt termelnek, a megfelelő hűtésük pedig kardinális. Az ASHRAE (American Society of Heating, Refrigerating and Air-Conditioning Engineers) ajánlása szerint egy adatközpontban 18-27 Celsius fokos hőmérséklet az ideális, a páratartalomnak pedig 60 százalék körül kell lennie. Ha az üzemeltetők nem figyelnek erre, nagyobb az esély a berendezés meghibásodására, és az eszközök élettartamának sem tesz jót. Nem véletlen, hogy a nagy techcégek a természeti adottságokat is figyelembe veszik egy új adatközpont telepítéskor, sokan a hűvösebb északi országokat választják, így Svédországot, Norvégiát. De vannak más érdekes helyszínválasztások, például az Alpok alatti hosszú alagútrendszerben is laknak szerverek,

Szobából kontinensekre

A Facebook a többi gigavállalatnál is nagyobb méretekben gondolkodik, hiszen elképesztő ütemben növekvő adatmennyiséggel kell megbirkóznia. A 2004-ben született Facebook még Mark Zuckerberg kollégiumi szobájából indult a Harvard Egyetemen, akkor még egyetlen szerveren futott a kezdetleges oldal. Ahogy a Facebook nő, úgy az adatközpontok méretét is növelni kell.

„Amikor a Facebookot eleinte csak egy kis csoport használta, és nem jelenített meg fotókat, videókat, az egész szolgáltatás elfért egyetlen szerveren” – mesélte Jonathan Heiliger, a Facebook korábbi technikai üzemeltetési elnöke. 2010-ben már 60 ezer szervert kellett bevetni, ami 2008 áprilisában még csak 10 ezer, 2009-ben pedig 30 ezer volt. Ma lényegesen nagyobb számokról beszélhetünk, bár a Facebook már nem közöl hivatalos adatokat a szerverek pontos számáról.

Napjainkra gigantikus adatközpontok szolgálják ki a közösségi cég szolgáltatásait, amik eltérő kontinenseken nyugszanak. Egy adatközpontban több tízezer hálózatba kötött szerver dolgozik, a külső világhoz pedig optikai kábelekkel kapcsolódnak. Minden alkalommal, amikor megosztunk valamit a Facebookon, ezek a szerverek fogadják be az információkat, hogy aztán azok eljussanak az ismerőseinkhez. De ez az infrastruktúra szolgál ki több mint egymillió olyan weboldalt és applikációt, amik a Facebook Connect platformot használják. A cég szervereinek és tárhelyeinek összessége minden alkalommal összedolgozik, amikor betöltjük az oldalt.

Egy felhasználó hírfolyamának betöltéséhez jellemzően több száz szerver dolgozik össze, miközben több tízezernyi egyedi adatdarabot dolgoz fel, majd az információt kevesebb mint egy másodperc alatt leszállítja

– írta a cég korábban.

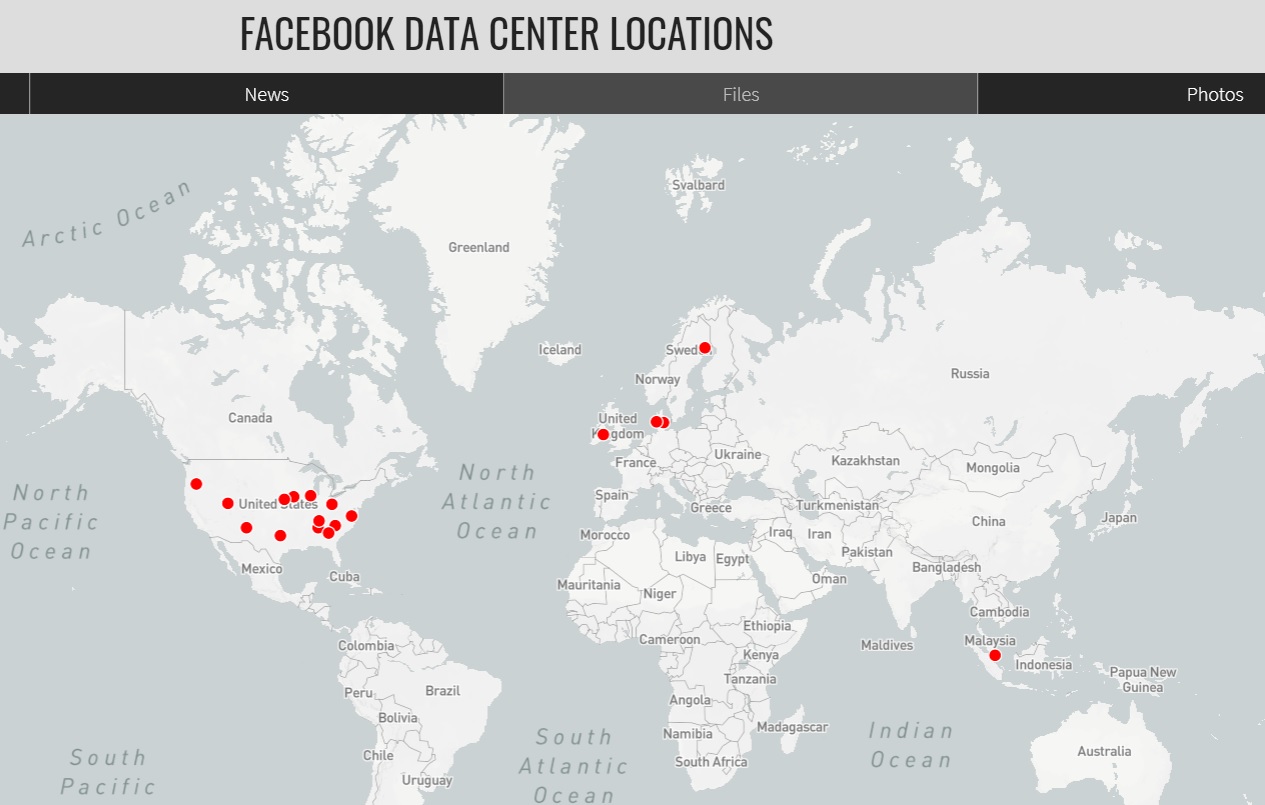

A Facebooknak jelenleg 18 adatközpontja van, nagy részük az Egyesült Államokban található, és egyes épületek jelenleg is építés vagy bővítés alatt állnak. Az első saját tervezésű szerverfarmot 2013-ban fejezték be Oregonban öt év építkezés után, Prineville-ben, a másodikat pedig Észak-Karolinában, Forest Cityben, amikor még csak 800 millió felhasználója volt a cégnek. Később a svédországi Luleában, majd az iowai Altoonában bővültek. De vannak adatközpontok az új-mexikói Los Lunasban és a texasi Fort Worthben, az államokon kívül pedig Dániában, Írországban, Szingapúrban, Svédországban találhatók ilyen létesítmények.

A Facebook nyíltan és átláthatóan kezeli az adatközpontok terveit és a használt hardvereket. 2011-ben indították el az Open Compute Projectet, amelynek

A project a Facebook Prineville-i adatközpontjának áttervezéséből született. A központok viszont nem egyformák, a helyszíntől függően például más elven működik a hűtés. Ami közös, hogy mindegyik megújuló energiát használ. A cég 2018-ban jelentette be egyedi vízhűtéses megoldását is, a StatePoint Liquid Cooling rendszert.

A Facebook adatközpontjai közül az egyik legérdekesebb a svédországi Lulea közelében található, ez volt az első, amit az USA-n kívül építettek. A városka 100 km-re található az északi sarkkörtől, és a téli hónapokban gyakori a mínusz 40 fok körüli hőmérséklet. Hűtés terén már alapból jó a helyzet, hiszen a központ a sarki zimankót fordítja előnyére. A levegőt ventillátorok szívják be az épületbe, és a közel 15 ezer négyzetméteres alapterületen lévő több tízezer szerver felé fújják. A központban 150-en dolgoznak, 25 ezer szerverre jut egy adminisztrátor. Ők szükség esetén elektromos robogókkal száguldoznak a hat focipálya méretű labirintusban. A helyi hatóságok szerint Luleában 1979 óta nem volt egyetlen áramkimaradás sem. A közeli folyókra vízerőműveket építettek, a központ innen nyeri a megújuló energiát. A szerverpark bejelentésekor Zuckerberg jó pár fotót megosztott a profilján, és idézte Emilie De Clercq technikust is, aki azt nyilatkozta:

Hogy mi a legnagyobb kihívás a munkában? Eljutni az adatközpontba kocsival, amikor kint mínusz 30 fok van.

Ennek fényében talán egy kicsit már jobban érthető, miért is kellett hat órán át nélkülöznünk a közösségi óriás különböző szolgáltatásait.