Nagy felháborodást keltett a múlt héten, mikor a Twitterre kikerült egy gépi tanulásos szoftver által generált kép, ami az Egyesült Államok első fekete elnökét, Barack Obamát ábrázolta fehér bőrű emberként. A Face Depixelizer nevű eszköz képes a rossz, pixeles minőségű fotókból tiszta arcokat ábrázoló képeket készíteni, de a dolog láthatóan nem mindig úgy sül el, ahogy az szerencsés lenne. A program a PULSE nevű algoritmust használja, amit eredetileg a Duke University diákjai fejlesztettek.

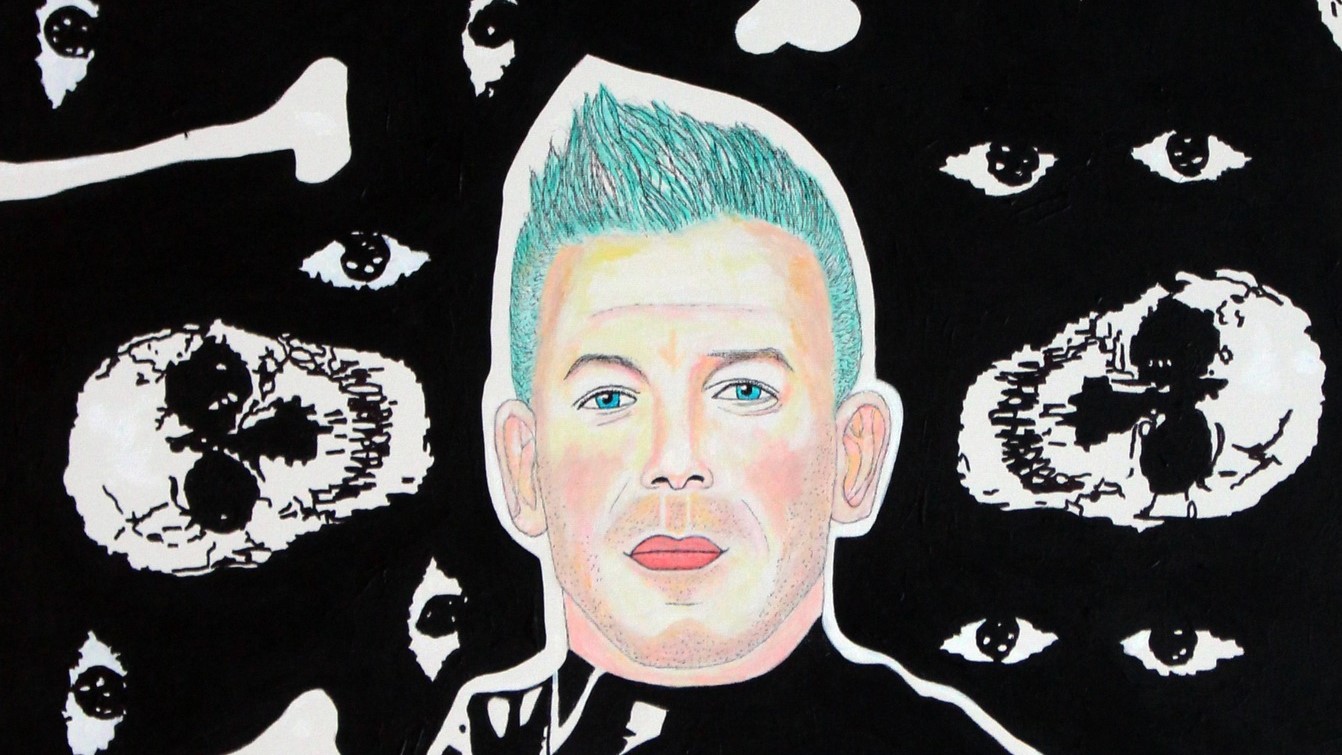

A kérdéses végeredményt Robert Osazuwa Ness mérnök, valamint az altdeep.ai fejlesztője tette közzé, aki egy pixeles Obama arcképet táplált be a PULSE-ba, ám az algoritmus végül egy fehér férfi képét adta ki. És nem csak az egykori elnök, de Lucy Liu színésznő egyedi vonásai is elvesztek, aki egy hétköznapi fehér nővé alakult, nagy szemekkel. Ness mindezzel arra próbálta felhívni a figyelmet, hogy az algoritmusok fejlesztőinek elfogultsága, részrehajlása a végeredményeket is meghatározza.

This image speaks volumes about the dangers of bias in AI https://t.co/GsoQqSr3XP

— Brad Wyble (@bradpwyble) June 20, 2020

Denis Malimonov, a Face Depixelizer programozója szerint az eszköz nem arra készült, hogy helyreállítsa és tökéletesítse a gyatra minőségű képet, hanem arra, hogy a mesterséges intelligencia (MI) egy újat alkosson belőle. A pixeleket helyreállítani ugyanis lehetetlen feladat, az algoritmus csak próbálkozik, hogy miként nézhetett ki korábban a felvételen látható személy. Túl sokat nem szabad várni tőle: a bűnügyi sorozatok terjesztették el azt a téves koncepciót, hogy egy szoftver képes úgy belenagyítani egy rossz minőségű, pixeles fotóba, hogy abból értékelhető részleteket nyerjenek ki a nyomozók.

A mesterséges intelligenciával dolgozó eszközök is csak kitöltik a hézagokat, tippelnek, hogy a korábban látott felvételek alapján mi szerepelhetett az adott fotó egy pontján. Az úgynevezett mélytanuló algoritmusokat úgy képezik ki, hogy egy nagy adathalmazban fedezzenek fel hasonlóságokat és mintákat, majd a frissen bejövő adatokat a korábbi tapasztalatok alapján értelmezzék. Gyakorlatilag a korábban látott rengeteg arcképből tanulják meg, hogyan néznek ki az emberek, és milyen vonásaik vannak.

Már jó ideje probléma

Nem ez az első eset, hogy rasszizmussal vádolnak egy programot: 2017-ben a FaceApp képszerkesztő kapott kemény kritikákat, amikor a szépítő funkció a babapofi mellett világosabb bőrszínt varázsolt a felhasználóknak, köztük Obamának. A fejlesztők utólagos magyarázatából kiderült, hogy szándékosságról szó sincs. A FaceApp mesterséges intelligenciájának fejlesztéséhez olyan nyílt projektekből használtak fel kódokat, mint például a Google-féle Tensorflow, így alapvetően nem az app működésével volt baj.

A neurális hálózat kiképzéséhez használt, betáplált referenciafotók miatt viselkedik így az alkalmazás. A fejlesztők nem figyeltek a diverzitásra a fotók válogatásakor, és mivel feltehetően több világos bőrszínű képet kapott a rendszer, ez kihatott a végeredményre is. Ez esetben arról volt szó, hogy az adatbázis, amiből dolgozott a program, nem megfelelő arányban tartalmazott képeket nem fehér bőrű emberekről.

A Face Depixelizerben dolgozó PULSE algoritmussal is hasonló a helyzet: a StyleGAN nevű modellt használja, ami a Flickr képmegosztó platformon keresztül elérhető fotókkal dolgozik. A fejlesztők szerint így diverzebb adatokhoz tudnak hozzáférni, de még így sem lehet megkerülni bizonyos részrehajlásokat. Ennek eredményeként a PULSE nagyobb eséllyel generál fehér arcokat – az előítéletes MI annak az eredménye, hogy előítéletes adatokból tanult.

Az egész a társadalomból eredeztethető

A probléma, miszerint az ember által létrehozott MI elfogult, már jó ideje téma a gépi tanulásos közösségben. Az AI-val kapcsolatos etikai aggodalmak nem új keletűek, egy ideje már folyik a diskurzus, hogy például a nem fehér emberek, illetve nők arcán pontatlanabbul teljesítenek az arcfelismerő szoftverek, nehezebben ismerik fel a fekete bőrűek arcát, mint a fehérekét. Amennyiben a forrásként bevitt adathalmaz nem pontos és nem reprezentatív, a végeredmény sem lesz az.

Éppen ezért a techcégeknek is nagyobb felelősséggel kell tervezniük a saját szolgáltatásaikat. A Microsoft már megfogalmazott olyan fő irányelveket, amelyek mentén az etikai szempontoknak is megfelelő szolgáltatásokat lehet tervezni. A két fő elem a pártatlanság és a megbízhatóság: az MI-rendszereknek minden embert egyenlőként kell kezelniük, mindenkinek előnyöket kell kínálniuk.

A megbízhatóság és pontosság kérdése is fontos, lévén az algoritmus sem tökéletes. Gyorsan fejlődnek ugyan a rendszerek, de még messze vannak a tökéletestől. A folyamatos teszteléshez pedig be kell vonni külső feleket is, akik pártatlanul tudják felderíteni a rendszerek hibáit.

Több kutató is úgy gondolja, hogy a mesterségesintelligencia-kutatás területén jelentkező részrehajlás a szélesebb körű társadalmi egyenlőtlenség eredménye, így az adatok megváltoztatása sem oldaná meg tökéletesen a problémát. Ha a jelenlegi világot jól reprezentáló adatokat sikerülne összeállítani, akkor sem lehetne garantálni a tökéletes eredményt. Ha például egy tudós képét akarnánk megtalálni, és ehhez az elmúlt évszázadok kutatóinak képeiből tanulna az algoritmus, kevésbé gondolná, hogy egy nő is lehet kutató, mivel az ismert tudósoknak csak kis százaléka nő.

Alexia Jolicoeur-Martineau PhD-hallgató szerint a kutatók közt is nagyobb diverzitás kéne, hogy a gépi tanulás területén is feloldható legyen a részrehajlás. Ha csak fehér férfi kutatók dolgoznak egy projekten, nagyobb rá az esély, hogy egyoldalú adatokkal, metódussal, megközelítéssel dolgoznak. Tehát a mesterséges intelligenciával foglalkozó szakemberek közt több lenne a színes bőrű és a nő, jobb eséllyel lehetne kiszúrni, ha egy készülő program diszkriminatív.